วิธีใช้ Robots.Txt เพื่อบล็อก Subdomains

เว็บไซต์เป็นวิธีที่ดีในการโปรโมตธุรกิจขนาดเล็กของคุณรวมถึงแสดงผลิตภัณฑ์และคุณสมบัติที่เป็นเอกลักษณ์ของคุณ หากคุณจัดการเว็บไซต์ขนาดใหญ่คุณอาจใช้โดเมนย่อยสองสามโดเมนและแต่ละโดเมนย่อยจะมีโฟลเดอร์ของตัวเองในเว็บโฮสต์ของคุณ หากคุณไม่ต้องการให้โปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหาแยกวิเคราะห์และจัดทำดัชนีโดเมนย่อยบางรายการคุณสามารถใช้ไฟล์ robots.txt เพื่อบล็อกพวกเขา

1

คลิกปุ่มเริ่มที่มุมล่างซ้ายของหน้าจอ

2

พิมพ์ "Notepad" ในช่องค้นหาที่ด้านล่างของเมนูเริ่ม

3

คลิก "Notepad" ในส่วนโปรแกรมที่ด้านบนของเมนูเริ่มเพื่อเปิด Notepad เอกสารใหม่จะถูกสร้างขึ้นโดยอัตโนมัติใน Notepad

4

แทรกสองบรรทัดเหล่านี้ในเอกสารแผ่นจดบันทึกเพื่อป้องกันไม่ให้โรบอตทั้งหมดแยกวิเคราะห์โดเมนย่อย:

ตัวแทนผู้ใช้: * ไม่อนุญาต: /

5

กด "Ctrl-S" เพื่อเปิดหน้าต่าง "บันทึกเป็น"

6

พิมพ์ "robots.txt" ในช่อง "ชื่อไฟล์" เลือกโฟลเดอร์ที่คุณต้องการบันทึกไฟล์และคลิก "บันทึก" เพื่อบันทึก

7

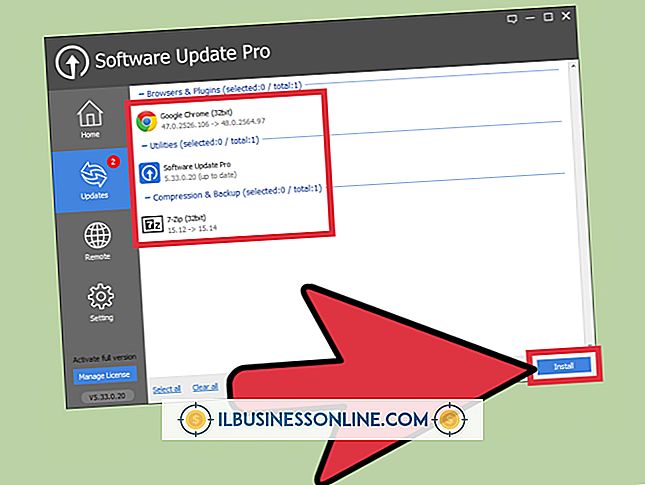

อัปโหลดไฟล์ robots.txt ที่คุณบันทึกไว้ในไดเรกทอรีรากของแต่ละโดเมนที่คุณต้องการป้องกันจากซอฟต์แวร์รวบรวมข้อมูลของเครื่องมือค้นหา ไดเรกทอรีรากเป็นไดเรกทอรีระดับบนสุด

ปลาย

- คุณสามารถอัปโหลดไฟล์โดยใช้ซอฟต์แวร์ไคลเอนต์ FTP หรือแม้แต่ตัวจัดการไฟล์เว็บโฮสต์ของคุณ